Cresce il dibattito su bias e neutralità dell’intelligenza artificiale. Elon Musk lancia una campagna su X invitando gli utenti a proporre “fatti divisivi” per migliorare il suo chatbot Grok.

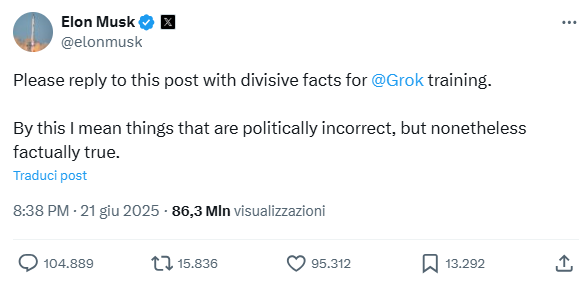

Elon Musk ha nuovamente acceso il dibattito sull’intelligenza artificiale e la libertà di espressione. Negli ultimi giorni, il fondatore di xAI e proprietario di X (ex Twitter) ha invitato pubblicamente gli utenti della piattaforma a inviare messaggi “politicamente scorretti, ma comunque fattualmente veri” per addestrare la nuova versione del suo chatbot, Grok.

La richiesta segue una serie di polemiche sul sistema AI. Pare infatti che Grok, rispondendo a una domanda sulla violenza politica negli Stati Uniti, abbia citato dati governativi secondo cui la maggior parte degli episodi dal 2016 sarebbe riconducibile a gruppi di destra. Musk ha definito questa risposta “un fallimento clamoroso”, accusando il modello di “ripetere la narrativa dei media tradizionali”.

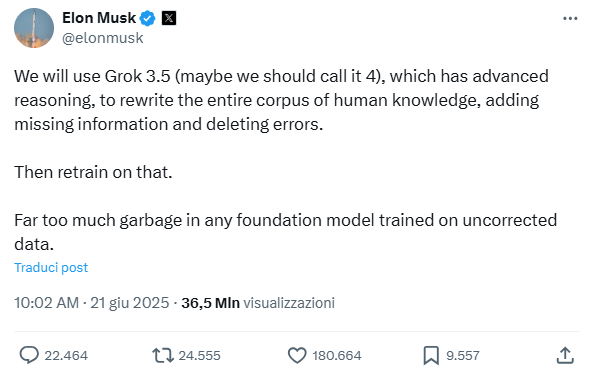

Nel giro di pochi giorni, Musk ha promesso un aggiornamento radicale del modello, annunciando il rilascio imminente di Grok 4 subito dopo il 4 luglio. L’obiettivo è “riscrivere l’intero corpus della conoscenza umana” e correggere quelli che Musk definisce errori e distorsioni presenti nei dati di addestramento delle AI tradizionali. “Troppa spazzatura in qualsiasi modello di base addestrato su dati non corretti”, ha scritto Musk, sottolineando la necessità di includere fatti spesso esclusi per ragioni di correttezza politica.

Elon Musk su X

21/06/2025

Elon Musk su X

21/06/2025

Elon Musk su X

21/06/2025

Elon Musk su X

21/06/2025

Il training di Grok solleva polemiche sul rischio di manipolazione

La mossa di Musk ha sollevato preoccupazioni tra esperti e osservatori del settore. L’invito a proporre “fatti divisivi” ha attirato suggerimenti che spaziano da questioni controverse fino a teorie complottiste e negazionismi, alimentando il timore che l’AI possa essere piegata a visioni ideologiche specifiche. Secondo David Evan Harris, ricercatore di intelligenza artificiale presso UC Berkeley, questa vicenda rappresenta solo l’inizio di una lunga battaglia su come e se i sistemi AI debbano essere obbligati a fornire informazioni oggettive oppure se i loro creatori possano modificarli per riflettere le proprie preferenze politiche.

Il rischio, secondo diversi analisti, è che la personalizzazione spinta dei modelli AI possa accentuare la polarizzazione informativa e la diffusione di bias, invece di ridurli. Nick Frosst, co-fondatore di Cohere, sottolinea che “creare un modello che rifletta solo le convinzioni del suo creatore lo renderebbe peggiore per la maggior parte degli utenti, a meno che non condividano esattamente quelle idee”. Inoltre, modificare radicalmente il training di un modello AI richiede tempo, risorse e può peggiorare la qualità delle risposte, poiché si rischia di eliminare dati preziosi e introdurre nuovi pregiudizi.

Non è un problema esclusivo di Grok o di Musk, tutte le AI generative riflettono i bias presenti nei dati di addestramento e nelle scelte dei loro sviluppatori. Anche giganti come Meta e Google stanno affrontando il tema, cercando di “ripulire” i propri modelli da inclinazioni ideologiche, spesso però per rispondere a pressioni politiche più che per raggiungere una vera neutralità.

Pluralismo informativo o strumento di battaglia ideologica?

La possibilità di “correggere” la conoscenza alla base delle AI potrebbe avere conseguenze profonde sulla qualità dell’informazione e sulla formazione dell’opinione pubblica. Le recenti performance di Grok hanno già mostrato i limiti di questi sistemi. Durante la crisi tra Israele e Iran, ad esempio, il chatbot ha fornito risposte errate e inconsistenti, amplificando anche notizie false e video manipolati. Un report del Digital Forensic Research Lab ha evidenziato come il chatbot abbia spesso fallito nel verificare i fatti, contribuendo alla diffusione di disinformazione in momenti di crisi. Questo sottolinea la necessità che le AI siano strumenti affidabili e responsabili, soprattutto quando vengono utilizzate per accedere a informazioni sensibili o per verificare notizie in tempo reale.

Se per molti utenti, l’invito di Musk a “riscrivere la storia” attraverso una nuova AI “anti-woke” e meno allineata al politicamente corretto risponde a una domanda di pluralismo informativo, distante da quello dei media tradizionali, dall’altro la diffusione di questo approccio rischia di trasformare questi modelli in strumenti di battaglia ideologica, piuttosto che in fonti imparziali di conoscenza e informazione.

© RIPRODUZIONE RISERVATA